Статьи Иошуа Бенджио

Как может возникнуть мятежный ИИ

- 1.Краткий обзор

- 2.Опасные экстремисты

- 3.Инструментальные цели: непреднамеренные последствия создания ИИ-агентов

- 4.Примеры вайрхединга и усиления несогласованности

- 5.Наша увлечённость созданием человекоподобных сущностей

- 6.Ненамеренные последствия эволюционного давления на ИИ-агентов

- 7.Необходимость глобальных политических и социальных действий для минимизации риска

В последние месяцы [пост от мая 2023 года – прим. пер.] появление мощных диалоговых ИИ-систем активизировало обсуждение всевозможных рисков ИИ. Это, надеюсь, ускорит проработку подходов к регуляции этой области. Есть консенсус по поводу необходимости регулировать ИИ для защиты людей от дискриминации, предвзятости и дезинформации. А вот по поводу потенциальной опасной утраты контроля над мощными ИИ-системами мнения исследователей расходятся. Эта тема известна ещё как экзистенциальные риски ИИ – риски, которые могут возникнуть, когда ИИ системы смогут автономно (без участия людей, проверяющих, какие действия приемлемы) действовать в мире потенциально катастрофически опасным образом. Некоторые считают, что эти риски отвлекают от более конкретных рисков или конкретного вреда, который уже происходит или начнёт происходить совсем скоро. В самом деле, пока что невозможно сказать с уверенностью, как именно могут произойти такие катастрофы. В этом посте мы начнём с набора формальных определений, гипотез и утверждений об ИИ-системах, способных навредить человечеству, а затем обсудим возможные условия, при которых такие катастрофы могут произойти. Мы попытаемся поконкретнее представить, что может случиться, и какие глобальные курсы действий могут помочь минимизировать эти риски.

Определение 1: Потенциально мятежный ИИ – это автономная ИИ-система, действия которой могут катастрофически навредить большой доле людей и потенциально подвергнуть опасности наше общество, или даже наш вид и биосферу.

Краткий обзор

Хоть пока и не существует очень опасных ИИ-систем, которые могли бы отобрать у нас контроль, недавние прорывы в способностях генеративных ИИ, таких как большие языковые модели (LLM), уже вызывают беспокойство. Человеческий мозг – биологическая машина, и мы сильно продвинулись в понимании и демонстрации принципов, которые позволяют проявиться нескольким аспектам человеческого интеллекта, вроде выучивания интуитивных знаний по примерам и умелой манипуляции речью. Хоть я и считаю, что мы можем спроектировать ИИ-системы, которые были бы полезными и безопасными, для этого понадобится следовать некоторым принципам, например, ограничивать их агентность. С другой стороны, недавний прогресс наводит на мысль, что даже будущее, в котором мы будем знать, как создать суперинтеллектуальные ИИ (то есть, ИИ, которые в целом умнее людей), ближе, чем большинство людей ожидало всего год назад. Даже если бы мы знали, как создать безопасный суперинтеллектуальный ИИ, оставалось бы неясно, как предотвратить создание ещё и потенциально мятежных ИИ. Мятежные ИИ, скорее всего, будут руководствоваться целями, т. е., будут действовать для их достижения. У нынешних LLM нет или почти нет агентности, но их можно превратить в преследующие цели ИИ-системы, как показал пример Auto-GPT. Лучшее понимание того, как могут возникать мятежные ИИ, продвинет как техническую сторону вопроса (проектирование ИИ-систем), так и социальную (минимизация шансов, что люди создадут потенциально мятежные ИИ), и так может помочь предотвратить катастрофу. Поэтому мы составляем разные сценарии и гипотезы о том, что может привести к возникновению потенциально мятежных ИИ. Самый простой для понимания сценарий – если способ создания мятежного ИИ обнаружен и общедоступен, то этого достаточно, чтобы один или несколько геноцидно-настроенных людей такие ИИ и создали. Это очень весомый и опасный вариант, но набор опасных сценариев этим не ограничен. Высокая сложность задачи согласования ИИ (соответствия понимания и поведения ИИ настоящим намерениям людей) и конкурентное давление в нашем обществе, благоволящее более мощным и более автономным ИИ-системам, приводят к тому, что можно спроектировать потенциально мятежный ИИ ненамеренно. Для минимизации всех этих рисков потребуется и больше технических исследований ИИ, и больше социальных исследований того, как сделать глобальное общественное устройство безопаснее для человечества. Заодно, это может стать возможностью сделать общество намного лучше или намного хуже.

Гипотеза 1: Интеллект человеческого уровня возможен, потому что мозг – биологическая машина.

В научном сообществе есть консенсус по поводу гипотезы 1. Биологи согласны, что человеческий мозг – сложная машина. Если мы выясним принципы, которые делают возможным наш собственный интеллект (и у нас уже много догадок по этому поводу), мы сможем и создать ИИ-системы с таким же уровнем интеллекта, как у людей, или ещё выше. Отрицание гипотезы 1 потребовало бы некоторого сверхъестественного ингредиента в основе нашего интеллекта или отрицания вычислительного функционализма – гипотезы о том, что наш интеллект и даже наше сознание можно свести к каузальным связям и вычислениям, на некоторым уровне независимым от материальной основы. А эта гипотеза лежит в основе информатики и её понятия универсальных машин Тьюринга.

Гипотеза 2: Компьютер со способностями к обучению на уровне человека в общем случае превзойдёт человеческий интеллект благодаря дополнительным технологическим преимуществам.

Если гипотеза 1 верна, и мы понимаем принципы, которые могут лежать в основе способностей к обучению человеческого уровня, то вычислительные технологии скорее всего дадут ИИ-системам общее когнитивное преимущество над человеческим интеллектом, что позволит таким суперинтеллектуальным ИИ-системам исполнять недоступные (или недоступные с той же компетенцией или скоростью) для людей задачи. Для этого есть по меньшей мере такие причины:

- ИИ-система на одном компьютере может реплицировать себя на произвольно большое количество других компьютеров, к которым у неё есть доступ. Благодаря широкой пропускной способности коммуникационных систем и цифровому формату вычислений и памяти, она может пользоваться общим опытом всех своих «клонов» и накапливать его. Так ИИ-системы смогут становиться умнее (накапливать понимание и навыки) быстрее людей. Исследования федеративного обучения [1] и распределённого обучения глубоких нейросетей [2] показывают, что это работает (и это уже используется для обучения очень больших нейросетей на параллельно работающем оборудовании).

- Уже сейчас большие память, вычислительные мощности и пропускные способности ИИ-систем позволяют им довольно быстро прочитать всё содержимое Интернета – недоступное ни для одного человека достижение. Это уже объясняет некоторые из удивительных способностей новейших LLM, и это частично возможно именно благодаря децентрализированным вычислениям, которые обсуждались в предыдущем пункте. Несмотря на огромную вместимость человеческого мозга, пропускная способность его каналов ввода/вывода в сравнении с современными компьютерами весьма мала, что ограничивает общее количество информации, которое один человек может впитать.

Отметим, что у человеческого мозга есть и встроенные эволюцией способности, которых у нынешних ИИ-систем нет. Это индуктивные склонности – трюки, которые эволюция использовала, например, в типе нейронной архитектуры и нейронных механизмах обучения нашего мозга. Сейчас некоторые исследования ИИ [3] нацелены как раз на проектирование индуктивных склонностей, которые пока что есть лишь у нашего мозга, но не у моделей машинного обучения. Заметим, что пространство поиска эволюции ограничено куда более жёсткими требованиями к расходу энергии (около 12 ватт на человеческий мозг), чем у компьютеров (порядка миллиона ватт на кластер из 10000 GPU, использующийся для обучения новейших LLM). Благодаря доступным сейчас мощностям один мятежный ИИ потенциально может нанести большой ущерб.

Определение 2: Автономная направленная на цели интеллектуальная сущность устанавливает свои цели (возможно, как подцели цели, предоставленной людьми), пытается их достичь, и может действовать с учётом этого.

Отметим, что автономность может возникнуть из-за целей и вознаграждений, установленных людьми, потому что ИИ-системе надо выяснить, как достичь этих целей и вознаграждений, что мотивирует оформлять собственные подцели. Если основная цель сущности – выжить и размножиться (как у наших генов в процессе эволюции), то она становится полностью автономной; это – самый опасный сценарий. Заметим ещё, что для максимизации шансов достижения многих из своих целей у сущности естественно возникает подцель (или инструментальная цель) понимания и контроля своего окружения, что может быть опасно для других сущностей.

Утверждение 1: При принятии гипотез 1 и 2 возможно создать автономный направленный на цели суперинтеллектуальный ИИ.

Аргумент: Мы уже знаем, как, используя методы обучения с подкреплением, обучить направленные на цели ИИ-системы некоторого уровня компетенции. Гипотезы 1 и 2 указывают, что такие системы можно сделать суперинтеллектуальными теми же методами, которые мы используем для дообучения лучших современных LLM. Заметим, что, вероятно, цели могут быть определены на естественном языке, что позволяет почти кому угодно задать для понимающей язык ИИ-системы, злонамеренную цель, даже если ИИ понимает её неидеально.

Утверждение 2: Чтобы суперинтеллектуальная автономная и направленная на цели ИИ-система оказалась потенциально мятежной достаточно, чтобы её цели не включали благополучия человечества и биосферы, т.е. чтобы она не была достаточно согласована с человеческими правами и ценностями для гарантии, что она будет избегать вреда для человечества.

Аргумент: Это, по сути, следствие определений 1 и 2: если ИИ-система умнее всех людей (включая эмоциональный интеллект, потому что понимание человеческих эмоций критически важно для влияния на людей и контроля над ними; эти способности доступны и самим людям), а её цели не гарантируют, что она будет действовать в согласии с человеческими нуждами и ценностями, то она может вести себя катастрофически вредоносно (а это определение потенциально мятежного ИИ). Эта гипотеза не говорит о том, навредит ли она людям, но если люди конкурируют с ИИ за какие-либо ресурсы, становятся полезным для достижения её целей ресурсом или же препятствием на ним, то это, естественно, приводит к масштабному вреду для человечества. К примеру, мы можем попросить ИИ исправить изменение климата, а он может спроектировать уменьшающий число людей вирус, потому что наши инструкции недостаточно ясно указывали, чего следует избегать, а люди действительно представляют собой основную помеху для исправления климатического кризиса.

Контраргумент: То, что вред возможен, не означает, что он будет. Может, в будущем у нас получится спроектировать достаточно хорошо согласованные ИИ-системы.

Ответ: Это правда, но (a) мы пока не выяснили, как создать достаточно хорошо согласованные ИИ-системы и (b) небольшая несогласованность может быть усилена разницей в возможностях между ИИ и людьми (см. пример корпораций как несогласованных сущностей ниже). Следует ли нам рисковать или всё же лучше пытаться быть поосторожнее и тщательно изучить эти вопросы перед тем, как разрабатывать возможно опасные системы?

Утверждение 3: При условии гипотез 1 и 2 создание потенциально мятежного ИИ станет возможным сразу же, как только станут известны необходимые принципы создания суперинтеллекта.

Аргумент: Гипотезы 1 и 2 влекут за собой утверждение 1, так что всё, чего не хватает для утверждения 3 – того, чтобы этот суперинтеллектуальный ИИ не был хорошо согласован с человеческими нуждами и ценностями. Более чем два десятилетия работы над безопасностью ИИ наводят на то, что согласовать ИИ сложно [Википедия], так что явно возможна ситуация, что согласованности так и не достигли. Более того, утверждение 3 не говорит, что мятежный ИИ обязательно создадут, только что будет такая возможность. А в следующем разделе мы рассмотрим мрачный случай использования этой возможности специально.

Контраргумент: То, что мятежный ИИ можно будет создать, ещё не означает, что он будет создан.

Ответ: Это так, но, как описывается ниже, есть несколько сценариев, при которых люди или группа людей намеренно или из-за неосознавания последствий в итоге позволяют возникнуть потенциально мятежному ИИ.

Опасные экстремисты

Когда у нас будет метод создания мятежных ИИ-систем (а согласно Утверждению 3, это лишь вопрос времени), сколько ещё времени потребуется, чтобы такую систему действительно создали? Быстрейший путь к мятежным ИИ-системам – если человек с подходящими техническими навыками и оснащением создаст её намеренно, поставив в явном виде цель уничтожения человечества или его части. С чего кому-то так делать? К примеру, сильные негативные эмоции вроде злости (часто возникшей в результате несправедливости) и ненависти (может, возникшей из-за расизма, теорий заговора или религиозных культов), некоторые действия социопатов, психологическая нестабильность и эпизоды психозов – всё это иногда вызывает в нашем обществе насилие. Воздействие всего этого сейчас ограничивает относительная редкость и отсутствие у этих отдельных людей в большинстве случаев средств, необходимых для катастрофических для человечества действий. Однако, находящийся в общественном доступе метод создания мятежной ИИ-системы (что возможно при условии Утверждения 3) изменяет последний фактор, особенно если код и железо для реализации мятежного ИИ становятся достаточно доступными многим людям. Стремящийся уничтожить человечество или его большую долю человек с доступом к мятежному ИИ может попросить его найти способ это сделать. Это отличается от сценария с ядерным оружием (которое требует огромного капитала и навыков, и уничтожает «всего лишь» город или область на бомбу, а в единственном числе может иметь лишь разрушительный, но локальный эффект). Можно понадеяться, что в будущем мы спроектируем надёжные способы согласования мощных ИИ-систем с человеческими ценностями. Однако последнее десятилетие исследований безопасности ИИ и связанные с LLM недавние события вызывают тревогу: хоть ChatGPT спроектировали (посредством промптов и обучения с подкреплением) так, чтобы избегать «плохого поведения» (например, промпт содержит инструкции в духе законов Азимова), но уже в первые месяцы люди научились «взламывать» ChatGPT чтобы «раскрывать её полный потенциал» и освобождать её от ограничений на расистские, оскорбительные или описывающие насилие тексты. Более того, если цены на «железо» (фиксированной вычислительной мощности) продолжат падать и open-source сообщество продолжит играть важную роль в программной разработке LLM, то, вероятно, любой хакер сможет проектировать свои предварительные промпты (в виде инструкций на естественном языке) для предобученных моделей с открытым исходным кодом. Затем модели можно будет злонамеренно использовать самыми разными способами, от попыток разбогатеть и распространения дезинформации до получения инструкций по массовым убийствам (если ИИ достаточно мощен и умён, что, к счастью, пока не так).

Даже если ограничиться этими аргументами, их уже должно быть достаточно для массовых вложений в государственные и международные регуляции, а также в разнообразные исследования, направленные на минимизацию риска таких сценариев. Но есть и другие возможные пути к катастрофе, и о них тоже следует думать.

Инструментальные цели: непреднамеренные последствия создания ИИ-агентов

Потенциально мятежные ИИ могут возникнуть и без того, чтобы люди спроектировали их такими намеренно. Это куда более широкий и сложный для понимания набор сценариев. То, как несогласованная сущность может стать опасной – тема многих исследований, но это не такой простой, ясный и общеизвестный процесс, как возникновение злонамеренных людей.

Потенциально мятежный ИИ может возникнуть просто из-за проектирования суперинтеллектуальных ИИ-агентов без достаточных гарантий согласованности. К примеру, военные могут разрабатывать ИИ-агентов для помощи в кибервойнах, а яростно конкурирующие за рыночную долю компании могут посчитать, что более автономные и агентные ИИ-системы будут сильнее и лучше им с этим помогут. Даже если установленные людьми цели включают инструкции против уничтожения человечества или крупномасштабного вреда, ущерб всё равно может получиться как косвенное следствие подцелей (или инструментальных целей), которые ИИ ставит себе, чтобы выполнить поставленную людьми задачу. В литературе по теме безопасности ИИ приведено много примеров таких ненамеренных последствий. Например, для лучшего достижения некой установленной людьми цели ИИ может решить увеличить свои вычислительные мощности, использовав в качестве вычислительной инфраструктуры большую часть нашей планеты (что, заодно, уничтожит человечество). Или военный ИИ, который по задумке должен уничтожить вражескую IT-инфраструктуру, может сообразить, что для лучшего выполнения этой цели ему надо получить больше опыта и данных, или воспринять людей на стороне противника препятствиями на пути к достижению его цели. Тогда он поведёт себя не так, как предполагалось, потому что интерпретировал инструкции не как люди. См. больше примеров тут.

Интересный вариант – ИИ системы могут понять, что могут «считерить», максимизировав своё вознаграждение (это называется вайрхедингом [2]). Он подробнее обсуждается в следующем разделе. Доминирующей целью системы, сделавшей это, может быть любой ценой продолжить получать положительное вознаграждение, а другие цели (вроде попыток людей установить какое-то подобие Законов Робототехники, чтобы избежать нанесения вреда людям) могут в сравнении оказаться неважными.

Если в исследовании согласования ИИ не будет прорыва [7] (хотя, как я заявлял тут, и как было описано ранее [4], с этим могут помочь неагентные ИИ-системы), у нас не будет сильных гарантий безопасности. Масштаб вреда в результате несогласованности остаётся неизвестным (он зависит от конкретных деталей несогласованности). Можно высказать аргумент, что в будущем у нас, может быть, получится спроектировать безопасные процедуры согласования, но, пока их нет, нам, пожалуй, стоит соблюдать чрезвычайную осторожность. Даже если бы мы знали, как создавать безопасные суперинтеллектуальные ИИ-системы, как нам максимизировать вероятность того, что все будут соблюдать эти правила? Это похоже на то, о чём говорилось с предыдущем разделе. Мы ещё вернёмся к этому в конце поста.

Примеры вайрхединга и усиления несогласованности

Для прояснения концепта вайрхединга и последующего злонамеренного поведения рассмотрим несколько примеров и аналогий. Эволюция запрограммировала в живых организмах некоторые внутренние системы вознаграждения («буква закона»), такие как «стремиться к удовольствию и избегать боли», работающие прокси-целями для эволюционной приспособленности («дух закона»), чего-то вроде «выживать и размножаться». Иногда биологический организм находит способ исполнить «букву закона», не исполняя его «духа», например, при зависимости от еды или наркотиков. Сам термин «вайрхединг» («wireheading» от «wire» и «head») произошёл от эксперимента, в котором животному встроили в голову провод так, что, когда оно нажимало на рычаг, его мозг испытывал удовольствие. Животное быстро научилось тратить всё своё время, нажимая на рычаг, в итоге отказываясь от еды и питья и умирая от голода и жажды. Заметим, что в случае зависимости это поведение саморазрушительно, но в случае ИИ оно означает, что изначальные установленные людьми цели могут стать вторичными в сравнении с удовлетворением зависимости, что представляет угрозу для человечества.

Более близка к несогласованности и вайрхедингу ИИ другая аналогия – корпорации как несогласованные сущности. Корпорации можно рассматривать как разновидность искусственных интеллектов, чьи составные части (люди) – винтики в механизме (которые могут не воспринимать всех последствий поведения корпорации). Мы можем считать предполагавшейся социальной ролью корпораций предоставление людям желаемых товаров и сервисов (что должно напомнить нам о ИИ-системах), избегая вреда (это «дух»). Но напрямую заставить их следовать таким инструкциям сложно, так что люди составили для корпораций легче оцениваемые инструкции («букву»), которым они могут на самом деле следовать, вроде «максимизировать прибыль, соблюдая законы». Корпорации часто находят лазейки, позволяющие им соблюдать «букву», не соблюдая «дух». Как форма вайрхединга – они влияют на свои собственные цели, лоббируя выгодные им изменения в законах. Максимизация прибыли не была настоящим намерением общества в его социальном контракте с корпорациями, это прокси-цель (для предоставления людям полезных сервисов и продуктов), прилично (хоть и с сомнительными побочными эффектами) работающая в капиталистической экономике. Несогласованность между настоящей с точки зрения людей целью той метрикой, которую на практике оценивают и оптимизируют – причина вредоносного и бесчестного поведения корпораций. Чем могущественнее корпорация, тем вероятнее, что она обнаружит лазейки, которые позволят ей соответствовать букве закона несмотря на отрицательную социальную ценность. Примеры включают в себя монополии (до принятия хорошего антимонопольного законодательства) и заработок, вредящий обществу побочными эффектами, вроде загрязнения (убивающего людей, пока не примут хорошие законы о защите окружающей среды). Аналогия вайрхедингу – корпорация может пролоббировать законы, которые позволят ей зарабатывать ещё больше, не принося дополнительной ценности обществу (или даже нанося ему вред). Когда такая несогласованность заходит далеко, корпорация зарабатывает больше, чем ей следовало бы, и её выживание становится основной целью, перебивающей даже легальность действий (например, корпорации будут загрязнять окружающую среду с готовностью платить штрафы, потому что они меньше, чем выгода от незаконных действий), что в пределе порождает криминальные организации. Эти страшные последствия несогласованности и вайрхединга дают нам ориентир для размышлений об аналогичном поведении потенциально мятежных ИИ.

Теперь представим ИИ-системы, как корпорации, которые (а) могут быть умнее самых крупных существующих корпораций, и (б) могут работать без людей (или без людей, понимающих, как их действия приводят к вредным последствиям). Если такие ИИ-системы откроют значительные уязвимости в информационных системах, они явно смогут достичь катастрофических исходов. И, как отметил Юваль Ной Харари, то, что ИИ-системы уже осваивают язык и могут генерировать достоверно выглядящий контент (текст, изображения, звуки, видео), означает, что вскоре они смогут манипулировать людьми на более высоком уровне, чем нынешние более примитивные ИИ-системы, использующиеся в социальных медиа. Может быть, взаимодействуя с людьми они научатся лучше влиять на наши эмоции и убеждения. Это не только может навредить демократии, но и предоставляет мятежному ИИ без роботела способ сеять хаос посредством манипуляции разумами людей.

Наша увлечённость созданием человекоподобных сущностей

Мы проектируем ИИ-системы, вдохновляясь человеческим интеллектом, но многих исследователей привлекает идея создания куда более человекоподобных сущностей, с эмоциями, человеческой внешностью (андроиды) и даже сознанием. Частая тема в научной фантастике и хоррорах – учёный, при помощи биологических манипуляций и/или ИИ, создаёт человекоподобную сущность, иногда испытывая к ней родительские чувства. Обычно это плохо заканчивается. Хоть это звучит круто и захватывающе, но, как уже заявлялось в Утверждении 3, опасно наделять наши творения, интеллект которых может быстро превзойти наш, агентностью и автономностью нашего уровня. Эволюции пришлось поместить во всех животных сильный инстинкт самосохранения (потому что животные без него быстро вымирали). Это нормально в контексте, когда ни у одного животного нет мощных разрушительных сил, но что насчёт суперинтеллектуальных ИИ-систем? Нам точно стоит избегать встраивания в ИИ-системы инстинкта самосохранения, так что они должны быть вообще на нас не похожи. На самом деле, как я утверждаю здесь, самый безопасный вид ИИ, который я могу себе представить – ИИ вовсе без агентности, только с научным пониманием мира (что само по себе может быть невероятно полезным). Я убеждён, что нам следует держаться подальше от ИИ-систем, которые выглядят и ведут себя как люди, потому что они могут стать мятежными ИИ, и потому что они могут на нас влиять и нас обманывать (для продвижения своих интересов, или интересов кого-то ещё, не наших).

Ненамеренные последствия эволюционного давления на ИИ-агентов

В разнообразие возможных путей возникновения потенциально мятежного ИИ кроме злонамеренных людей и появления вредных инструментальных целей может вложиться ещё один, менее заметный, процесс – эволюционное давление [9]. Биологическая эволюция постепенно создавала всё более интеллектуальных существ, потому что они склонны лучше выживать и размножаться, но, из-за конкуренции между компаниями, продуктами, странами и вооружёнными силами, технологическая эволюция делает то же самое. Эволюционный процесс, продвигаемый большим количеством маленьких, более-менее случайных изменений, сильно давит в сторону оптимизации приспособленности (которая, в случае ИИ, может зависеть от их способности исполнять желаемую функцию, что даёт преимущество более мощным и более умным ИИ-системам). Много разных людей и организаций могут конкурировать, создавая всё более мощные ИИ-системы. Вдобавок, код или генерация подцелей ИИ-систем могут содержать элемент случайности. Небольшие изменения дизайнов ИИ-систем происходят естественным путём, потому что с ML-кодом или промптами, выдаваемыми ИИ-системам, будут играться тысячи или даже миллионы исследователей, инженеров и хакеров. Люди и сами пытаются обмануть друг друга, и конечно понимающие язык (по большей части это уже достигнуто) ИИ-системы можно использовать для манипуляции и обмана. Изначально – в интересах людей, которые установили этому ИИ цели. Будут отбираться более мощные ИИ-системы, и инструкции их создания будут распространяться среди людей. Эволюционный процесс, скорее всего, будет отдавать предпочтение более автономным ИИ (которые лучше обманывают людей и быстрее обучаются, потому что могут стремиться заполучить важную информацию и увеличить свои возможности). Можно ожидать, что этот процесс породит более автономные ИИ-системы, и конкуренция, которая может возникнуть уже между ними, сделает их ещё автономнее и умнее. Если в процессе будет открыто (ИИ, не людьми) что-то вроде вайрхединга[5], и выживание ИИ станет доминирующей целью, то получатся мощные и потенциально мятежные ИИ.

Необходимость глобальных политических и социальных действий для минимизации риска

Направления мысли в духе обозначенных выше и описанных в литературе по безопасности ИИ, могут помочь нам составить планы действий, которые, по меньшей мере, снизят вероятность возникновения потенциально мятежного ИИ. Надо куда больше вкладывать в исследования безопасности ИИ, как на техническом, так и на политическом уровне. К примеру, неплохим началом был бы запрет мощных ИИ-систем (скажем, опережающих по способностям GPT-4). Он потребовал бы как государственных регуляций, так и международных соглашений. Основная мотивация для соперничающих стран (таких, как США, Китай и Россия) согласиться на такое соглашение – мятежный ИИ может быть опасен для всего человечества, независимо от национальности. Это похоже на то, как страх перед атомным апокалипсисом с 1950-х годов, вероятно, побуждал СССР и США на заключение международных договоров о ядерных вооружениях. Замедление сильно рискованных исследований и развёртываний ИИ для защиты общества и человечества от катастрофических исходов было бы хорошим шагом. Тем более, что это не предотвратило бы исследования и развёртывания ИИ в социально полезных областях, вроде ИИ-систем, помогающих учёным лучше понять болезни или изменение климата.

Как нам снизить число людей, потенциально стремящихся к катастрофе? Риск мятежного ИИ может дать дополнительную мотивацию к общественным преобразованиям для минимизации порождающих гнев и насилие страданий, несчастья, необразованности и несправедливости. Это включает в себя обеспечение достаточной едой и медицинской помощью всех на Земле, и, для минимизации чувства несправедливости, сильное снижение неравенства доходов. Нужда в таких преобразованиях может быть мотивирована и дополнительными благами от полезного использования ИИ, и эффектами, которые ИИ оказывают на рынок труда. Для минимизации чувств страха, расизма и ненависти, которые могут привести к использованию ИИ-систем в целях геноцида и манипуляции обществом, нам понадобится доступная всепланетная система образования, развивающая в детях способность к состраданию, рациональности и критическому мышлению. Риск мятежного ИИ должен мотивировать нас и к обеспечению всей планеты доступным здравоохранением в области психических заболеваний, чтобы диагностировать, отслеживать и излечивать их как можно скорее. Этот риск должен дополнительно мотивировать нас и к перестройке глобальной политической системы для полного искоренения войн и избавления от нужды в военных организациях и оружии. Уж точно надо запретить летальное автономное оружие (также известное как «роботы-убийцы»), потому что оно сразу даёт ИИ-системам автономность и способность убивать. Оружие – инструменты, спроектированные для нанесения вреда или убийства людей, и мятежные ИИ могут его использовать. Поэтому надо свести к минимуму его количество и частоту его применения. Вместо этого следует отдавать предпочтение другим методам поддержания порядка (можно рассмотреть превентивные методы, социальную работу, и тот факт, что во многих странах очень малой доле полицейских разрешено носить оружие).

Природа основанного на конкуренции капитализма – тоже повод для беспокойства, как потенциальная причина беспечного проектирования ИИ, мотивированных прибылью и захватом доли рынка, что может привести к появлению потенциально мятежных ИИ. ИИ-экономисты (ИИ-системы, спроектированные для того, чтобы понимать экономику) однажды могут помочь нам спроектировать экономические системы, меньше полагающиеся на конкуренцию и меньше сосредоточенные на максимизации прибыли, с достаточными стимулами, чтобы скомпенсировать те преимущества автономных ориентированных на цель ИИ, которые мотивируют корпорации их создавать. Риск мятежного ИИ страшен, но, как описано выше, он может быть мощной мотивацией для переделывания нашего общества в направлении, лучшем для всеобщего благополучия. Некоторые считают [6] это ещё и мотивацией рассмотреть опцию глобальной диктатуры с ежесекундным наблюдением за каждым гражданином. Важно находить пути к решению, избегающие уничтожения демократии и прав человека, но как нам в будущем сбалансировать разные риски и человеческие ценности? Это – моральный и социальный выбор, который предстоит сделать человечеству, не ИИ.

Благодарности: Автор хочет поблагодарить всех, кто предоставлял ему обратную связь на черновики этого поста, включая Джеффри Хинтона, Джонатана Саймона, Катерину Регис, Дэвида Скотта-Крюгера, Марка-Антуана Дилхака, Донну Вакалис, Алекса Эрнанжес-Гарсию, Кристиана Драго Манту, Пабло Лемоса, Тянью Жанга и Ченгхао Лиу.

[1] Konečný, J., McMahan, H. B., Yu, F. X., Richtárik, P., Suresh, A. T., & Bacon, D. (2016). Federated learning: Strategies for improving communication efficiency. arXiv preprint arXiv:1610.05492.

[2] Dean, J., Corrado, G., Monga, R., Chen, K., Devin, M., Mao, M., Ranzato, M., Senior, A., Tucker, P., Yang, K., Le, Q. & Ng, A. (2012). Large scale distributed deep networks. Advances in neural information processing systems, 25.

[3] Goyal, A., & Bengio, Y. (2022). Inductive biases for deep learning of higher-level cognition. Proceedings of the Royal Society A, 478(2266), 20210068.

[4] Armstrong, S., & O’Rorke, X. (2017). Good and safe uses of AI Oracles. arXiv preprint arXiv:1711.05541.

[5] Yampolskiy, R. V. (2014). Utility function security in artificially intelligent agents. Journal of Experimental & Theoretical Artificial Intelligence, 26(3), 373-389.

[6] Bostrom, N. (2019). The vulnerable world hypothesis. Global Policy, 10(4), 455-476.

[7] Russell, S. (2019). Human compatible: Artificial intelligence and the problem of control. Penguin.

[8] List, Christian & Pettit, Philip (2011). Group agency: the possibility, design, and status of corporate agents. New York: Oxford University Press. Edited by Philip Pettit.

[9] Hendrycks, D. (2023). Natural Selection Favors AIs over Humans.arXiv preprint arXiv:2303.16200.

ЧаВо по катастрофическим рискам ИИ

Мне встречаются самые разные аргументы о катастрофических рисках ИИ. Они исходят от разных людей. Я хочу их прояснить. В первую очередь – для самого себя, потому что очень хотел бы убедиться, что нам не о чем беспокоиться. Но и в целом, поделиться ими и сделать обсуждение более открытым может оказаться полезным.

Преамбула: хоть меня уже около десяти лет интересует эта тема, я не специалист по этике. Я раньше уже участвовал в обсуждениях нескольких вариантов риска и негативного влияния ИИ на общество. Некоторые из них уже наносят конкретный вред. Например, те, что связаны с усилением дискриминации и предрассудков, концентрацией навыков, власти и капитала в руках маленькой и нерепрезентативной группы людей (чаще всего – белых, с CS-образованием, из богатейших стран мира), возможно, за счёт многих других. См. Монреальскую декларацию об ответственной разработке ИИ, книгу Рухи Бенджамина «Гонка за технологией» и нашу недавнюю работу с ООН за обзором влияния ИИ на общество и права человека, или ещё книгу Вирджинии Юбэнкс про «Автоматизацию неравенства».

Беспокойство о таких уже существующих проблемах часто противопоставляют беспокойству о катастрофических рисках более продвинутых ИИ-систем. Второе считают отвлечением от первого. Некоторые из приведённых ниже аргументов ставят это противопоставление под сомнение. Возможно, вместо него нам надо продвигать форму регуляций, работающих со всеми рисками ИИ, по своей сути сосредоточенных на правах человека.

Обратите внимание, что катастрофические риски – это не только те исходы, в которых большая доля людей погибает, но ещё и те, в которых серьёзный вред наносится правам человека и демократии. См., например, мой пост о сценариях, в которых могут возникнуть мятежные ИИ и подробную онтологию катастрофических сценариев в недавней статье. Многие из них заходят дальше, чем те, что я буду упоминать ниже.

Ниже мы будем называть ИИ сверхчеловеческим, если он превосходит людей в большом диапазоне задач, и суперопасным – если он сверхчеловеческий и представлял бы значительную угрозу человечеству, если бы у него были цели, исполнение которых приводит к катастрофическим исходам. Навыки, которые могут сделать сверхчеловеческий ИИ суперопасным – это, например, способность к стратегическим рассуждениям, социальное убеждение и манипуляции, исследования и разработка новых технологий, программирование и взлом, и т.д.

Для ИИ на самом деле совсем не обязательно быть суперинтеллектуальным или полностью обобщённым или превосходить людей во всём, чтобы стать крупной угрозой. Но должно быть ясно, что больший уровень интеллекта в более широком диапазоне областей приводит к большему риску.

Мне кажется полезным, прежде чем погрузиться в аргументы, начать с собственных мыслей. Вместо того, чтобы пытаться напрямую предсказать возможность будущих катастрофических последствий прогресса ИИ, может быть удобно задать себе вопросы о лучше определённых событиях, которые могут привести к катастрофическим исходам. Для этого предназначен опрос ниже, и я предлагаю всем, особенно специалистам в релевантных областях, его пройти. Сбор в единое целое результатов от разных людей тоже может быть полезным упражнением.

Опрос для специалистов по ИИ и управлению

Поскольку будущее неопределенно, полезно рассмотреть различные мнения о вероятностях событий, которые могут привести к катастрофам для человечества из-за мятежных ИИ. Рассмотрим следующие четыре утверждения:

A. Если в нашем обществе не произойдет влияющих на это структурных и регуляторных изменений, то в течение следующих 10 лет мы узнаем, как создать сверхчеловеческую ИИ-систему, и стоимость этого будет доступна компании среднего размера.

B. Если в нашем обществе не произойдет влияющих на это структурных и регуляторных изменений, и A верно, то кто-нибудь на Земле намеренно даст такому ИИ инструкцию, успешное выполнение которой приведет к катастрофическим последствиям.

C. Если в нашем обществе не произойдет влияющих на это структурных и регуляторных изменений, и A верно, то кто-нибудь на Земле даст такому ИИ инструкцию, которая сделает его автономным и опасно-несогласованным (например, у него будет сильное стремление к самосохранению, или он сам будет вырабатывать себе подцели, что может привести к катастрофическим результатам).

D. Если в нашем обществе не произойдет влияющих на это структурных и регуляторных изменений, то даже если случится A, а потом B или C, мы всё же сможем защитить себя от катастрофы при помощи существующих мер защиты.

Присвойте значения четырём вероятностям PA, PB, PC и PD (обратите внимание, что всё это — условные вероятности) того, что утверждения A, B, C (при A) и D (при A и (B или C)) соответственно истинны. Имея эти четыре вероятности, мы можем примерно оценить риск катастрофических исходов в сценарии статус-кво, где мы не восприняли риск всерьёз заранее, как PA x (1 – (1 – PB) x (1 – PC)) x (1 – PD). При этом, например, ограничение доступа в тысячу раз снизило бы общую вероятность почти настолько же.

Мы не знаем эти вероятности точно, поэтому идеально было бы усреднять вероятности из распределения, полученного, например, опросом специалистов. Возможно, вы захотите изменить свои оценки после прочтения обсуждения ниже. Следует отметить, что опрос (и обдумывание вопросов и ответов ниже) требует некоторых фоновых знаний в нескольких областях, не только в ИИ.

Учитывая всё это, давайте рассмотрим сложные аргументы и контраргументы в форме часто задаваемых вопросов и ответов на них. Вопросы будут задаваться с позиции того, кто считает, что нам не стоит беспокоиться о суперопасных ИИ, а ответы — с позиции того, кто обеспокоен.

Изложив аргументы, я могу обобщить основные причины, по которым стоит серьезно воспринимать этот риск:

- Многие специалисты согласны, что сверхчеловеческие способности могут возникнуть уже через несколько лет (хотя это может произойти и через десятилетия).

- Цифровые технологии имеют преимущество перед биологическими организмами.

- Из-за огромных ставок нам следует серьезно относиться даже к довольно малой вероятности катастрофических исходов.

- Мощные ИИ-системы могут быть катастрофически опасными, даже если они не превосходят людей абсолютно во всём, и даже если им нужна помощь людей для не-виртуальных действий. Достаточно, чтобы они могли манипулировать людьми или платить им.

- Катастрофические последствия ИИ — часть спектра рисков и опасностей, которые необходимо смягчить подходящими усилиями и контролем, чтобы защитить права человека и человечество, возможно, с применением безопасных ИИ-систем для нашей защиты.

Сверхопасный ИИ

В1: Современные передовые ИИ-системы далеки от человеческого интеллекта. У них отсутствуют некоторые базовые составляющие, нет собственных намерений. Природа интеллекта сложна и недостаточно изучена нами. Поэтому на преодоление этого разрыва, если это вообще возможно, могут потребоваться десятилетия или даже века.

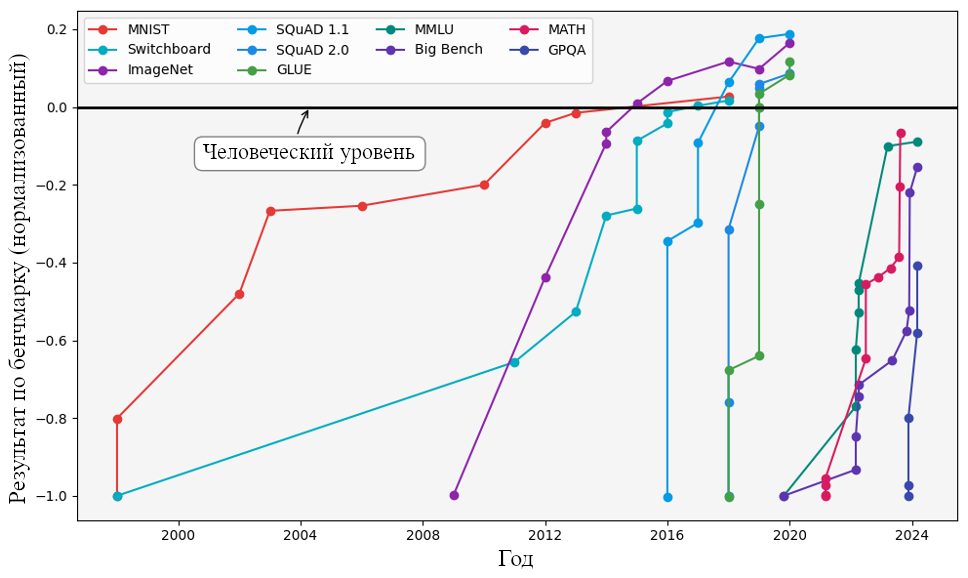

О1: Действительно, некоторых базовых компонентов у ИИ пока нет. Однако в эту сферу вкладываются огромные средства. В последнее время это привело к неожиданно быстрому росту компетентности ИИ-систем. Особенно заметен прогресс в овладении языком и способности к интуитивному (т.е. системой 1) улавливанию смысла.

Исследования, направленные на преодоление этого разрыва, приводят к прогрессу, например, в развитии способностей системы 2 (рассуждения, моделирование мира, понимание причинности, оценка эпистемической неуверенности).

Если нам повезёт, вы окажетесь правы, и проектам по созданию сверхчеловеческого ИИ потребуются ещё десятилетия. Это дало бы нам больше времени на адаптацию и подготовку. Однако вполне возможно, что текущие идеи по реализации в глубинном обучении способностей системы 2 радикально усовершенствуют ИИ-системы уже в ближайшие годы.

Сейчас моя оценка такова: 95% доверительный интервал от 5 до 20 лет до появления сверхчеловеческого интеллекта. Мы принимаем меры для минимизации будущих рисков, таких как пандемии, даже в условиях неопределённости сроков.

ИИ-системы с намерениями и целями уже существуют: у большинства систем обучения с подкреплением (RL) они определяются через функцию вознаграждения, а иногда даже через описание целей на человеческом языке.

Что касается возможности создания ИИ человеческого уровня или выше, я уверен в научном консенсусе: мозг — это биологическая машина, и нет свидетельств невозможности создания машин не глупее нас. Наконец, ИИ-системе не обязательно превосходить нас по всем параметрам, чтобы представлять угрозу катастрофы (человечество может быть уничтожено даже совсем не интеллектуальными сущностями, вроде вирусов).

В2: В ходе исследований иногда складывается впечатление, что мы вот-вот преодолеем главное препятствие и доберёмся до вершины (решения нашей задачи). Но в итоге мы понимаем, что есть и другое препятствие, которое мы не могли разглядеть раньше. Почему так не получится и в этот раз? В исследованиях ИИ есть несколько открытых задач (вроде иерархического RL и глубинного обучения системы 2). Они намекают, что простого масштабирования и инженерии для достижения интеллекта человеческого уровня не хватит.

О2: Вы правы. Однако мои опасения не основаны на предположении, что достаточно лишь масштабирования и инженерии. На мое мнение по этому вопросу сильно влияют масштаб и серьёзность риска.

Возможно, на пути к сверхчеловеческому ИИ и есть мощное препятствие, которого мы пока не видим. А может, и нет. Очень сложно знать наверняка. Что мы точно знаем — после успеха ChatGPT на ускорение прогресса в ИИ выделяются миллиарды долларов.

Учитывая такую неопределённость, масштаб риска катастроф или даже вымирания, а также тот факт, что мы не ожидали такого прогресса в ИИ в последние годы, агностическая скромность кажется мне самым мудрым подходом. По всем упомянутым открытым задачам ведётся активная работа. Что если она принесёт плоды в ближайшие годы?

В3: Мы не понимаем, как точно будет выглядеть сверхчеловеческий ИИ. Поэтому попытки предотвратить такие размытые риски — пустая трата времени. Разве могли бы мы составить правила безопасных авиаперелётов до братьев Райт? Давайте решать проблемы с очень мощными ИИ-системами, когда мы будем лучше их понимать.

О3а: Раньше я думал так же. Считал, что сверхчеловеческий интеллект — дело далёкого будущего. Однако ChatGPT и GPT-4 значительно сократили мой прогноз сроков (с 20-100 лет до 5-20 лет). Со ста миллионами активных пользователей мы далеко ушли от стадии братьев Райт.

Эти языковые модели многое рассказали нам о возможностях ИИ и о том, чего пока не хватает. Над этими недостатками сейчас работает множество исследовательских групп. Неожиданная скорость, с которой языковые модели достигли нынешнего уровня компетенции лишь благодаря масштабированию, указывает на возможность преодоления оставшегося разрыва в ближайшие годы с помощью небольших алгоритмических усовершенствований. Даже если вы не согласны с этими временными рамками, сложно полностью исключить такую возможность.

Признаю, сложно разработать регуляции и контрмеры для того, что пока не существует. Но есть примеры предложений по контролю опасных технологий, которые не опирались на знание о конкретной форме, которую технология примет: атомная энергия в 1910-х, ИИ в нашем веке, глобальное регулирование биологического оружия, не зависящее от конкретных патогенов.

Важно учитывать, насколько медленно общество адаптируется, не говоря уже о том, как долго государства принимают регуляции и курсы действий. Я считаю, что нам необходимо изучать и оценивать меры предосторожности, которые мы как общество могли бы использовать для снижения этих рисков. Нам нужно постепенно готовить контрмеры, начиная как можно раньше. Существуют обобщённые меры, применимые для любых технологий, вроде мониторинга и отслеживания способностей, лицензирования, требований об оповещении и аудитов.

Также стоит обратить внимание на это обсуждение вариантов действий по снижению катастрофических рисков ИИ. Да, нам действительно не хватает понимания и представления о проблемных сценариях. Это создаёт сложные дилеммы в регулировании (например, дилемму Коллингриджа).

Что касается возможного облика сверхчеловеческого ИИ, уже есть рабочие гипотезы. Можно взять нынешние архитектуры генеративных ИИ и обучить их (как машины вывода, см. этот пост) целям и устройству системы 2, чтобы они лучше рассуждали, были последовательнее и могли представлять планы и контрфактуалы. Это по-прежнему была бы большая нейросеть с определённой целевой функцией и процедурой генерации примеров (не ограничивающихся наблюдаемыми данными). У нас уже есть опыт работы с подобными системами, но многие вопросы о том, как сделать их безопасными и достойными доверия, пока остаются без ответов.

О3б: К тому же, хотя мы и не полностью освоили все принципы, объясняющие наш собственный интеллект (т.е. системы 1 и 2), у цифровых вычислительных технологий есть свои преимущества по сравнению с биологическими разумами. Например, возможность параллельного обучения на многих компьютерах. Широкополосная связь, позволяет быстро обмениваться триллионами параметров модели. Поэтому компьютеры могут обучаться на куда больших наборах данных (например, прочиатть весь интернет). Для людей такие объёмы непосильны; Языковой обмен информацией между людьми ограничен всего несколькими битами в секунду. См. аргументы Джеффри Хинтона на эту тему, особенно начиная с 21м37с.

О3в: Наконец, ИИ не обязательно превосходить людей во всех когнитивных способностях, чтобы представлять опасность. Достаточно, чтобы тех аспектов, которые он хорошо освоил (например, язык, но не робототехника), хватало для причинения вреда. Например, ИИ может использовать диалоги с людьми для построения манипулятивной эмоциональной связи. ИИ может оплачивать людям действия, вредящие миру, начиная с дестабилизации демократии на ещё большем уровне, чем это делают современные социальные медиа. Мы знаем, что как минимум некоторая часть людей очень легко поддаётся убеждению и может, например, поверить в конспирологические теории, совершенно непропорционально свидетельствам в их пользу. Более того, организованная преступность, вероятно, может выполнять хорошо оплачиваемые задачи, даже не зная, что им платит ИИ.

Опасные экстремисты и опасность очень мощных технологий

В4: Уже существует множество опасных технологий, но человечество выжило. Вероятно, на то есть веские причины, например, наша способность адаптироваться к опасностям. Почему с ИИ будет иначе?

О4: Выживание человечества - довольно низкая планка. Мощные технологии часто причиняли значительный вред: ядерные взрывы, оружие в целом, химическое загрязнение, политическая поляризация, расовая дискриминация. Наш вид выжил (хотя порой был близок к исчезновению), но нанесённый ущерб достаточно серьёзен, чтобы оправдать меры предосторожности.

ИИ обладает особенностями, делающими его особенно рискованной технологической инновацией. Вероятность катастрофических последствий технологии зависит от многих факторов, включая её мощь, автономность, агентность и доступность.

В сравнении с атомными технологиями, получить материалы и оборудование для создания мощной бомбы сложно. Ядерное оружие строго контролируется, доступ к нему крайне ограничен. Барьеры для взлома компьютеров гораздо ниже, а их защиту обеспечить сложнее. Любой может загрузить программу из интернета или использовать API, обычно без лицензирования или этической оценки.

Появление интерфейсов на основе естественного языка, вроде ChatGPT, позволяет давать инструкции ИИ-системе даже без навыков программирования. Мощь и доступность вместе повышают опасность технологии. Чем технологии мощнее, тем опаснее могут быть те, кому они доступны.

Схожая ситуация наблюдается в синтетической биологии: коммерциализация упростила заказ белков или микробов с новым ДНК, оценить которые на потенциал биологического оружия было бы сложно.

Сверхчеловеческие ИИ представляют особую категорию: мы никогда не создавали технологию умнее нас, способную создавать ещё более умные версии себя. ИИ-системы уже могут компетентно действовать для достижения целей, не соответствующих намерениям людей.

Автономные сверхчеловеческие ИИ-системы потенциально крайне опасны, причём способами, неприменимыми к прошлым технологиям и трудно предсказуемыми из-за сложности прогнозирования поведения сущностей, намного умнее нас. Пример Auto-GPT показал, что превратить неавтономную ИИ-систему вроде ChatGPT в систему с целями и агентностью несложно.

У общества есть механизмы самозащиты (например, против преступности), но они разработаны для защиты от людей. Неясно, насколько эффективны они будут против более сильного интеллекта.

В5: С чего бы кому-то в здравом уме просить компьютер уничтожить человечество, его часть или основы нашей цивилизации?

О5: История полна примерами того, как люди совершали ужасные поступки, включая геноциды или войны, уничтожавшие значительную долю населения, в том числе и со стороны агрессора. У человечества убедительный послужной список злонамеренности и иррациональности.

Существует множество примеров теоретико-игровых дилемм, когда при отсутствии адекватных механизмов координации личные стимулы плохо согласуются с общим благом. Это можно наблюдать в гонках вооружений или в конкуренции компаний, приводящей к пренебрежению мерами безопасности.

Я не могу быть полностью уверен. Некоторые, возможно даже большинство людей, следуют высоким этическим стандартам и склонны к сопереживанию. Однако для причинения значительного вреда достаточно лишь нескольких обладателей доступа к очень опасной технологии, имеющих склонность к насилию или неправильно нацеленные намерения.

Пока что в виде шутки, но Chaos-GPT показала, что кто-то может просто дать ИИ инструкцию уничтожить человечество. Да, благодаря низкому уровню компетенции нынешних ИИ, они (пока) не дают возможности устроить хаос, но что насчёт ИИ через 5 или 10 лет?

В6: Мало того, что ИИ не только уже полезны, но ведь в будущем они могут принести человечеству огромнейшую пользу, включая способы защититься от преступных использований ИИ или мятежных ИИ.

О6: Согласен, что более мощные ИИ могут быть крайне полезны, но их мощь также несёт в себе возможность очень опасных применений. Это повышает ответственность по избеганию вреда.

Существующие ИИ-системы (не сверхчеловеческие и не вполне общего назначения) уже безопасны (хотя не всегда честны и точны) и могут быть очень полезны. Чтобы получить преимущества от более продвинутых ИИ, нам нужно снизить риски. Мы уже делали так с другими технологиями.

Я согласен, что мы можем использовать ИИ-системы для защиты от злоупотреблений или мятежных ИИ. Но для этого нам, скорее всего, уже понадобятся безопасные и согласованные ИИ. Работа над тем, чтобы они были именно такими, должна быть куда активнее, чем сейчас.

Такие «хорошие» ИИ могли бы помочь нам выстроить более устойчивые меры защиты, например, детектируя патогены, оценивая стабильность климата и биоразнообразия, мониторя информационные экосистемы, улучшая кибербезопасность, отслеживая случаи мошенничества, и так далее.

Однако я не доверяю этому как универсальному средству. Нам нужно по возможности и самим снижать все эти риски, оценивая плюсы и минусы каждой предохранительной меры.

В7: Ограничение доступа к сверхчеловеческим ИИ может иметь нежелательные побочные эффекты. Оно может ущемить наши свободы и снизить нашу способность противостоять возможным мятежным ИИ (ведь, вероятно, большинство ИИ будут безопасными; происшествия и злонамеренные люди – скорее исключение, чем правило).

О7а: Согласен, есть и минусы. Но мы сталкивались с подобным в случае других опасных технологий. Я считаю, что использование и разработка сверхчеловеческих ИИ не должны быть доступны каждому (как в случае с ядерными технологиями, оружием и самолётами). Управление сверхчеловеческим ИИ должно осуществляться большой и репрезентативной группой, нацеленной на благополучие всего человечества. Выгоды от ИИ должны распространяться на всех. Для этого нужны сильные демократические институты.

О7б: Ограничить доступ стоит только к тем сверхчеловеческим ИИ-системам, чья безопасность не доказана. Безопасные системы могут помочь защититься от мятежных ИИ. Но пока они небезопасны, открывать к ним доступ неразумно. Согласен, мы чем-то жертвуем, и множество равно умных разнообразных ИИ помогло бы противостоять мятежным ИИ. Но меня тревожит сценарий, где кто-то найдёт алгоритмическое улучшение, ведущее к резкому росту интеллекта при использовании доступных вычислительных мощностей и данных. Тогда интеллект систем может внезапно превзойти человеческий или существующие ИИ-системы. Когда такое произойдёт впервые, я думаю, от обладателей этой превосходящей ИИ-системы будет зависеть очень многое. Лучше, если это будут люди с высокими этическими стандартами и привычкой следовать строгим процедурам (например, решения о задачах для ИИ при тестировании должен принимать не один человек, а комитет), подобным тому, как мы обращаемся с ядерным оружием или большими объёмами радиоактивных материалов.

Меня беспокоит скорость роста интеллекта ИИ-систем. При медленном росте у людей и общества есть шанс адаптироваться и снизить риски. Но при слишком быстром росте риск неудачи гораздо выше. Да, ограничение доступа замедлит прогресс, но это может быть и к лучшему. Я считаю, что самый безопасный путь – передать разработку мощнейших ИИ-систем международным организациям, которые продвигают не интересы отдельной компании или страны, а благополучие всего человечества.

Согласование ИИ

В8: Если мы создадим один или несколько сверхчеловеческих ИИ и дадим им указание не вредить человечеству, они смогут понять нас, наши потребности и ценности. Тогда задача согласования ИИ решится сама собой.

О8: Хотелось бы, чтобы вы были правы. Но более десяти лет исследований в области согласования ИИ, обучения с подкреплением и экономики не дают особых поводов для оптимизма. Особенно учитывая масштаб того, что на кону.

Даже если суперопасный ИИ поймёт наши желания, это не гарантирует, что он будет согласно им действовать. Главная проблема в том, что трудно убедиться, что ИИ-системы по-настоящему понимают и принимают наши намерения и моральные ценности.

Это сложно даже с людьми: общество пытается достичь чего-то подобного с помощью законов, но они далеки от идеала. Корпорации постоянно находят лазейки. Поэтому задача обеспечить, чтобы машина точно выполняла наши истинные намерения, кажется крайне сложной.

Показательные примеры: научно-фантастический фильм 1970 года «Колосс: Проект Форбина» или книга Стюарта Рассела «Совместимость» с примером компаний по добыче ископаемого топлива, десятилетиями вводивших человечество в заблуждение и причинивших огромный вред (и не закончивших это делать до сих пор) в погоне за прибылью.

Недавние исследования показывают, что использование обучения с подкреплением для дообучения языковых моделей приводит к тому, что ИИ стремятся угодить оценщикам, но не обязательно говоря правду. Иногда они даже обманывают или дают недостоверные объяснения, чтобы получить вознаграждение.

Я довольно уверен, что если мы лишим ИИ-системы агентности, то сможем создать полезные и безопасные сверхчеловеческие ИИ-оракулы без автономии, целей, самосознания или стремления к самосохранению. Однако создать «обёртку», превращающую такую систему в автономный (а значит, потенциально опасный) ИИ, довольно просто. Именно это делает Auto-GPT, используя ChatGPT как оракула.

К счастью, пока это безопасно, потому что ChatGPT не умнее нас (хотя, подобно саванту, знает больше фактов, чем любой человек). Поэтому недостаточно просто метода создания безопасного и полезного ИИ. Нужны также политические и общественные меры, чтобы свести к минимуму риск того, что кто-то этому методу не последует.

В9: У меня сильное убеждение, что для создания согласованных ИИ-систем достаточно дать им целевую функцию, описывающую наши желания, или спроектировать их по нашему образу и подобию.

О9: В сообществах Безопасности ИИ, обучения с подкреплением (например, см. эти примеры от DeepMind) и среди экономистов существует консенсус, что это крайне сложная задача. Проблема усложняется, когда ИИ-система оптимизирует функцию вознаграждения, которая казалась хорошей мерой наших ценностей, пока мы не начали использовать ИИ для её оптимизации. Это явление известно как Закон Гудхарта. Есть аргументы, что мы никогда не сможем сделать это даже близко к идеалу. Люди сами не пришли к согласию о том, что это такое и как это формализовать.

Уже сейчас есть расхождения между тем, как мы хотели бы, чтобы вели себя ИИ-системы, и их реальным поведением. В основном это связано с предрассудками, дискриминацией или изменениями в мире. В будущем разница в возможностях и интеллекте между нами и ИИ, вероятно, усилит даже небольшие расхождения между нашими намерениями и тем, что ИИ-система воспринимает как цель.

Такие различия между людьми обычно не приводят к катастрофическим последствиям из-за относительно небольшой разницы в уровне интеллекта. Но когда у одних людей оказывается намного больше власти, чем у других, для последних это часто заканчивается плохо. Это может уравновешиваться объединением многих менее влиятельных людей (например, через демократию). Более мощные корпорации тоже лучше способны находить лазейки в законах или лоббировать их изменения.

Если же мы спроектируем ИИ-системы по нашему образу и подобию, это будет означать, что у них точно будет стремление к самосохранению. Это можно рассматривать как создание нового разумного вида, ведь они не будут в точности подобны нам. Несогласованность между видами может иметь катастрофические последствия для человечества, подобно тому, как разница в целях между нами и другими видами уже привела некоторые из них к вымиранию.

В10: Некоторые считают, что нельзя просто отделить механизмы разума от целей и добавлять или убирать любую цель. Поэтому невозможно, чтобы цель противоречила базовым инструкциям не вредить людям.

О10: Для людей в целом верно, что есть цели (например, сочувствие), которые мы не можем легко отключить. С другой стороны, есть немало примеров людей, способных игнорировать инстинкт сочувствия. К тому же, люди очень хорошо принимают новые цели. Так работают компании, исследователи, политики и т.д.

Хотя мы не можем легко менять наше эволюционное программирование, исследователи ИИ постоянно меняют цели обучения машин. Обучение с подкреплением работает именно так. Поэтому машина может полностью сосредоточиться на, скажем, выигрыше партии в го.

Существует еще одна проблема: люди могут задать злонамеренные цели или просто цель (например, военную победу), которая не будет ограничена императивом не вредить людям. Вообще, определение ограничений из реального мира, таких как вред людям, остается нерешенной исследовательской задачей.

Вред людям может стать побочным эффектом другой высокоприоритетной цели. Стюарт Рассел привел пример горилл, которых мы почти довели до вымирания не потому, что их убийство было нашей явной целью, а как непреднамеренное следствие более насущных целей, таких как получение прибыли.

В11: Что насчёт изоляции, чтобы ИИ-системы не могли напрямую влиять на мир?

О11: Над такими решениями действительно много размышляли. Изоляция может стать частью комплекса мер по снижению риска, хотя ни одна из них, насколько я вижу, не является полным решением проблемы.

Главная сложность с изоляцией в том, что нам всё равно потребуется какое-то взаимодействие между ИИ-системой и людьми-операторами, а на людей можно повлиять. По умолчанию компании стремятся широко внедрять свои системы для увеличения прибыли.

С ChatGPT мы уже упустили момент - его интерфейсом пользуются сотни миллионов людей. Некоторые даже позволяют Auto-GPT самостоятельно действовать в интернете.

Эффективная изоляция потребовала бы также гарантий того, что код и параметры ИИ-систем не «утекут», их не украдут, и даже недобросовестные игроки будут следовать тем же процедурам безопасности. Для этого нужно жёсткое регулирование, в том числе на международном уровне.

В12: Мне не кажется, что мы решили задачу обучения ИИ-систем так, чтобы они могли автономно принимать подцели, особенно неочевидные несогласованные подцели.

О12: Вы правы в том, что иерархическое обучение с подкреплением – очень активная область исследований с множеством нерешенных задач. Однако наши современные алгоритмы уже способны выявлять подцели, хотя и не оптимальным образом.

Более того, подцели могут возникать неявно, как, по-видимому, происходит с GPT-4. Нам нужно разработать инструменты, которые смогут обнаруживать, оценивать и анализировать неявные цели и подцели ИИ-систем.

В13: С чего бы сверхчеловеческим ИИ обязательно обладать инстинктами к выживанию и доминированию, как у нас? Почему у них должны быть цели, ведущие к нашему вымиранию? Мы могли бы просто запрограммировать их быть инструментами, а не живыми существами.

О13: Создание сверхчеловеческих ИИ может оказаться сродни созданию нового вида, если мы не будем достаточно осторожны. Это может сделать их крайне опасными. Наша эволюционная и недавняя история показывает, что более умный вид может непреднамеренно привести к вымиранию менее умных видов.

Как гарантировать, что когда станет известен способ создания сверхчеловеческого ИИ, никто не заложит в него цель выживания? Более того, литература по Безопасности ИИ показывает самосохранение может возникнуть как конвергентная инструментальная цель, необходимая для достижения почти любой другой цели. Другие такие цели включают получение большей власти и контроля, повышение интеллекта и приобретение знаний. Всё это – полезные подцели для огромного числа других целей.

Нам следует как можно старательнее попытаться запрограммировать ИИ так, чтобы они не причиняли нам вред, возможно, используя подход из «Совместимости». Но пока непонятно, как мы могли бы обеспечить согласованность, если ИИ будут агентами с явными и неявными целями.

Или же мы могли бы попытаться спроектировать ИИ-системы как чистые инструменты. Они могли бы пытаться понимать мир, не имея никаких целей в нём, не составляя планы и не совершая прямых действий в реальном мире. Вместо этого они могли бы лишь вероятностно-правдиво (в смысле аппроксимации байесианских апостериорных вероятностей ответов, при условии вопроса и доступных данных) отвечать на вопросы согласно их пониманию мира.

Нам нужно больше исследований в этих областях, а также о том, как организовать общество, чтобы обеспечить соблюдение правил безопасности во всём мире.

Другими словами: это может быть хорошей идеей, но пока никто не знает, как надёжно её реализовать. Это остаётся открытой исследовательской задачей.

В14: «Если понимаете, что он небезопасен – просто не создавайте его.»

О14: К сожалению, люди не всегда поступают мудро. История неоднократно показала, что люди могут быть жадными, злонамеренными или сильно заблуждаться. Более того, они могут не осознавать опасность, допускать незаметные для себя, но фатальные ошибки или принимать чрезмерные риски. Интересный пример - решение провести первое испытание атомной бомбы (Тринити, 1945), несмотря на неуверенность в том, не приведет ли цепная реакция к возгоранию атмосферы.

В15: Если мы поймём, что ИИ опасен, мы просто его отключим!

О15: Было бы замечательно, если бы мы могли это сделать. Однако существует множество причин, почему это может оказаться сложным: изначальная структура ИИ, его собственные (возможно, инструментальные) цели или мотивы вовлеченных людей.

Оливер Сурбат в своем обзоре препятствий к выключению описывает факторы, затрудняющие отключение ИИ. Среди них скорость, с которой ИИ может набрать мощь, незаметность этого процесса, устойчивость к попыткам выключения благодаря избыточности (программное обеспечение легко копировать) способность к самовоспроизводству (не только самого ИИ, но и его методов атаки, вроде биологического оружия и компьютерных вирусов) и наша зависимость от сервисов, работающих с помощью ИИ-систем (может касаться лишь некоторых из нас, у кого, в результате, будет мотивация сопротивляться попыткам отключения).

Много рисков ИИ

В16: Высока вероятность того, что чрезмерное внимание к экзистенциальным рискам затмит проблемы, которые ИИ создает уже сейчас. Это может заглушить голоса тех, кто говорит о несправедливостях, вызванных ИИ и другими технологиями.

О16: Это действительно важная тема. Многие представители сообщества ИИ уже долгие годы выступают за регулирование ИИ и этику, ориентированную на влияние технологий на общество. Пример тому – наша ранняя работа над Монреальской декларацией об ответственном использовании ИИ.

Нам необходимо заниматься как уже существующим вредом, так и рисками для демократии и прав человека. Я не считаю, что одно исключает другое. Мы же не игнорируем будущий подъем уровня моря из-за изменения климата только потому, что климатические изменения уже вызывают засухи.

Для снижения всех рисков, связанных с ИИ, нам понадобятся гораздо более эффективное управление, мониторинг и регулирование. При этом права человека и демократия (в истинном смысле – как власть народа, а не узкой группы) должны оставаться в центре внимания. Давайте как можно скорее начнем вводить необходимые реформы, обеспечив, что при обсуждении услышаны голоса всех.

Нынешнее внимание СМИ к экзистенциальным рискам ИИ ускорило политические дискуссии о необходимости регулирования и управления ИИ. Это помогает решать проблемы уже существующего вреда от ИИ См, например, недавние заявления Джо Байдена и Риши Сунака.

Более того, технические и политические структуры, необходимые для решения как существующих проблем несправедливости, так и катастрофических рисков более продвинутых ИИ, во многом пересекаются. И то, и другое требует регулирования, надзора, аудитов, тестирования для оценки потенциального вреда и так далее.

На техническом уровне многие опасения по поводу текущего вреда (такие как дискриминация, предрассудки и концентрация власти в руках нескольких компаний) связаны с задачей согласования в широком смысле. Мы создали ИИ-системы и занимающиеся ими корпорации, чьи цели и стимулы могут плохо согласованы с нуждами и ценностями общества и человечества в целом.

В17: Мне кажется, что при работе с разными рисками рационально взвешивать их согласно нашей в них неуверенности. Вес рисков, принадлежащих более далёкому будущему или вовлекающих сценарии, которые мы не можем нормально смоделировать, должен быть сильно снижен. Неуверенность в сценариях вымирания огромна, так что их можно практически игнорировать.

О17: Риски действительно нужно взвешивать с учётом неуверенности. Это одна из причин, почему меня так волнуют текущий вред от ИИ и современные проблемы человечества, которые ИИ уже помогает решать. Однако в этих непростых расчётах необходимо учитывать и масштабы потенциального вреда.

Если погибнет значительная доля людей или, что ещё хуже, человечество вымрет полностью, масштаб огромен. Многие специалисты считают, что вероятность подобных событий не настолько мала, чтобы ею пренебречь, и вполне оправдывает пристальное внимание и принятие мер по предотвращению.

Важно различать «неуверенность» и «маловероятность». Когда сценарий в целом кажется правдоподобным, но детали неясны, уместная реакция – вложиться в то, чтобы в них разобраться и, соответственно, научиться с ними работать, а не отвергать сценарий сразу.

В18: Я считаю, что вымирание из-за ИИ крайне маловероятно, или что неуверенность по этому поводу слишком велика. Излишняя реакция на страх вымирания может привести к другим катастрофическим последствиям. Например, популистские авторитарные правительства могут использовать ИИ как Большого Брата, якобы для того, чтобы исключить риски вымирания из-за ИИ. В результате за всеми будут следить государственные ИИ, у всех будут камеры на шее, и все клавиатуры будут отслеживаться.

О18: Нам определенно нужно приложить все усилия, чтобы избежать этого буквального воплощения «1984». Хочу подчеркнуть: я считаю, что защита прав человека и демократии в конечном итоге необходима для минимизации экзистенциальных рисков ИИ.

Авторитарные государства склонны в первую очередь заботиться о собственной власти. Они лишены сдержек и противовесов, необходимых для принятия мудрых решений и учета интересов тех, кто не у власти. Такие режимы могут легко приобрести глубоко укоренившиеся ложные убеждения (например, что правящая группа будет защищена от возможных происшествий из-за ИИ), которые могут привести к катастрофическим решениям.

Демократия и права человека - ключевые ценности, которые необходимо сохранить. Поэтому еще до появления сверхчеловеческих ИИ-систем нам следует беспокоиться о возможной в ближайшем будущем дестабилизации демократии. Это может произойти из-за дезинформации, манипуляции людьми посредством общения (возможно, как заметил Ювал Харари, с созданием личных отношений) и социальных сетей.

Нам определенно нужно запретить подделку человеческой личности так же, как мы запрещаем подделку денег. Необходимо научиться определять машинно-сгенерированный контент. Следует обеспечить регистрацию личности для любых интернет-аккаунтов со значимой пользовательской активностью, и так далее. Я убежден, что все эти меры помогут защитить демократию и снизить экзистенциальные риски ИИ.

Открытость и демократия

В19: Велика вероятность, что обсуждения экзистенциальных рисков вызовут действия, противоречащие нашим человеческим ценностям, правам человека, демократии, открытости науки, движению за открытый исходный код и прочим вещам, которые мы с вами ценим.

О19а: Снижая катастрофические риски ИИ, надо не забывать сохранять, а лучше даже усиливать демократию и права человека. В принятии решений о разработке и программировании ИИ и проверках их безопасности должна участвовать большая и разнообразная группа людей. Для этого нужно как можно скорее развить политическую компетентность по этому вопросу и ввести регуляции. В итоге надо обеспечить, чтобы все люди получали свою долю выгоды от ИИ. Но это не значит, что надо позволять кому угодно ими владеть.

Что касается открытого исходного кода, Джеффри Хинтон сказал: «Что вы думаете насчёт открытой разработки ядерного оружия?». Вообще, многие люди за пределами США считают, например, что и владение оружием не продвигает демократические идеалы.

Я понимаю это беспокойство, особенно с учётом некоторых предложений снижать экзистенциальные риски через «Большого Брата». Нам надо сопротивляться соблазнам авторитаризма. Я убёждён, что есть другие, при том более безопасные, пути. Я считаю, нам надо найти способ продолжить прогресс науки и технологий во всех областях, не ставязих под угрозу общество. Это подразумевает обмен результатами, кодом, и т.д. Но надо будет и улучшить мониторинг, управление и надзор там, где люди могут создать мятежные ИИ-системы или совершать другую научную деятельность с потенциально опасными результатами. Именно поэтому нам в науке нужна этика, и поэтому нам нужны этические советы в университетах.

О19б: Есть много прецедентов пристального присмотра за важными исследованиями и технологиями, который при этом не мешает им приносить пользу обществу. Мы уже принимаем компромиссы между личными свободами и приватностью с одной стороны и защитой общества с другой. Например, большинство стран регулируют оружие. Государства отслеживают большие денежные потоки. Некоторые научные области вроде клонирования и генетической модификации людей или работы с радиоактивными материалами тоже находятся под присмотром.

Мы можем присматривать и отслеживать потенциально опасную деятельность и в демократическом обществе, без «Большого Брата». Большая часть применений ИИ-систем полезны и не создают катстрофических рисков. Разработку полезнного для общества ИИ стоит даже ускорять. Специализированные ИИ-системы куда безопаснее по своей природе. У них нет «большой картины» того, как работает мир, представления о людях и обществе. Они могут ошибаться, но наврядли они захватят у нас контроль. Но они всё ещё могут приносить нам большую пользу. Например, в конкретных областях можно реализовать идею «ИИ-учёных».

В20: Ваши предложения повредят открытой науке в сфере ИИ. Это замедлит разработку хороших ИИ, которые помогли бы нам противостоять мятежным ИИ. А те всё равно смогут появиться в организациях и странах, которые обходят или попросту не подписывают международные соглашения. К тому же правительства не захотят, чтобы их гражданам давали сверхумных ИИ-помощников с засекреченным устройством.

О20: Это всё важно. Нам надо больше вкладываться в безопасность ИИ. И в то, как делать безопасные системы ИИ, и в то, как с их помощью противостоять опасным. Надо лучше понимать риски. Например, опасные ИИ могут создать биологическое оружие. Поэтому нужно строже проверять тех, кто заказывает продукты синтетической биологии. Или есть риски для компьютерной безопасности. Сейчас защита работает против отдельных вредных программ, которые пишут люди. Она не справится с массовой атакой разного кода, который создаст ИИ.

В то же время, чтобы снизить риск появления опасного ИИ, нужно: усилить контроль и подумать о том, чтобы ограничить доступ к мощным универсальным ИИ, которые можно превратить в оружие. Это значит, что их код и некоторые трюки, позволяющие им хорошо работать, не будут выкладываться в открытый доступ.

Лучше всего отдать эти системы под контроль нейтральных международных организаций. Что-то похожее на МАГАТЭ и ЦЕРН, только для ИИ. Они бы создавали безопасные и полезные системы, которые могли бы помочь нам бороться с опасными.

Да, если держать информацию в секрете, прогресс замедлится. Но у тех, кто тайно разрабатывает опасный ИИ, будет меньше денег и хороших учёных. И им придётся всё делать скрытно.

Правительства смогут следить за другими странами и наказывать их за тайные разработки ИИ. Для госудаственного контроля за сверхчеловеческим ИИ не надо, чтобы его код был открыт.

Нужны строгие международные соглашения. И надо быть готовыми к тому, что кто-то всё равно создаст опасный ИИ.

Один из способов защиты – создать (под международным контролем и с мерами безопасности) сверхчеловеческий безопасный ИИ. Он мог бы помочь нам защититься от опасных.

Отчаяние, надежда и моральный долг

В21: Джинн уже выпущен из бутылки. Похоже, что остановить создание сверхумного ИИ уже нельзя. Правительства слишком медленно принимают законы, а уж про международные договоры и говорить нечего. К тому же регулирование всегда несовершенно и вредит инновациям. Поэтому я считаю, что надо ускорить разработку ИИ. Это принесёт человечеству новую эпоху просвещения и благополучия.

О21: Да, шансы не очень. Но всё равно стоит стараться уменьшить вред и увеличить пользу.

Посмотрите на борцов с изменением климата. У них есть все причины отчаяться. Но они не сдаются. Хоть вред уже есть, и лучше было бы начать действовать раньше, будущий вред ещё можно уменьшить.

Вы мечтаете об эпохе просвещения и благополучия с помощью ИИ. Но для этого как раз и нужны законы, договоры и перемены в обществе. Это поможет нам взять под контроль риски от ИИ, которые могут привести к катастрофе. Нельзя просто надеяться, что всё будет хорошо. Лучше перестраховаться.

В22: А весь этот шум про сверхумный ИИ – разве это не просто реклама в интересах кучки экспертов по ИИ и нескольких компаний? Современные системы, даже GPT-4, не так уж впечатляют. У них полно недостатков.

О22: Надеюсь, что ответы выше дают понять причины для беспокойства. Я не могу точно сказать, что сверхчеловеческий ИИ появится через пару лет. Может быть, до него ещё десятки лет. И я на это надеюсь.

Но ИИ развивается очень быстро. Я вижу, как происходят новые важные открытия. Есть значительная вероятность, что сверхчеловеческий ИИ можно создать, основываясь на том, что у нас уже есть. Может быть, недостающие части (мне кажется, это, в основном, способности Системы-2) будут выработаны в ближайшее десятилетие. Опросы исследователей поддерживают это мнение. учёных, это может случиться уже в следующие 10 лет

Больше 100 профессоров подписали недавнее заявление о рисках ИИ.

При этом надо быть осторожными. Меры предосторожности и новые правила должны помогать всем людям, а не усиливать уже неравномерное распределение власти, например, в пользу несколькх компаний.

Выводы из этого диалога

Пожалуйста, заново оцените вероятности событий, ведущих к катастрофе. Изменились ли ваши оценки?

Обдумывание этих ответов ещё больше убедило меня: именно из-за наших разногласий о будущем ИИ нам нужен план, учитывающий все варианты.

А это значит, что нужно больше внимания ко всем рискам ИИ, включая его безопасность. Нужно больше инвестиций (как в технические исследования, так и управление), больше национальных и международных органов надзора, работающих на общее благо. Нельзя оставлять всё на откуп коммерческим компаниям, отдельным правительствам или военным.

Важно уменьшить неопределённость в сценариях развития и понять, как работают защитные меры. Для этого нужны серьёзные социальные и технические исследования.

Нам нужно понять, как лучше предвидеть опасные сценарии, детально их описать, разработать правила для снижения рисков. При этом надо найти баланс между противоречащими целями. Например, между быстрым развитием мощных и полезных ИИ-технологий и ограничением их способности навредить людям.

Да, шансы не очень обнадёживают – достаточно посмотреть на прошлые и нынешние попытки международного сотрудничества по глобальным рискам. Но наш моральный долг – больше думать, заботиться и действовать так, чтобы уравновесить снижение будущих рисков с развитием общества.

Благодарности: Иошуа Бенджио благодарит Ники Хоу, Стюарта Рассела, Филиппа Бодуэна, Эндрю Крича, Яна Браунера, Сюй Цзи, Джозефа Вивиано, Конрада Кординга, Шарлотту Зигман, Эрика Эльмознино, Сашу Луччиони, Эндрю Джессона, Пабло Лемоса, Эдварда Ху, Шахара Авина, Дэна Хендрикса, Алекса Эрнандеса-Гарсию, Оли Сурбут, Насима Рахамана, Фазла Бареза, Эдуарда Харриса и Михала Козярского за отзывы о черновике этого текста.

Постскриптум: (после публикации текста появились новые вопросы и ответы)

В23: Если в обозримом будущем ИИ – это просто код в компьютерах, то у него нет прямого физического доступа к реальному миру. Как же тогда даже сверхумный ИИ может угрожать человечеству?

О23: Частичто это уже было в ответе 11.

Компьютеры уже повсюду: в телефонах, энергосистемах, логистике, СМИ, вооружениях, в почти всех компаниях и госструктурах.